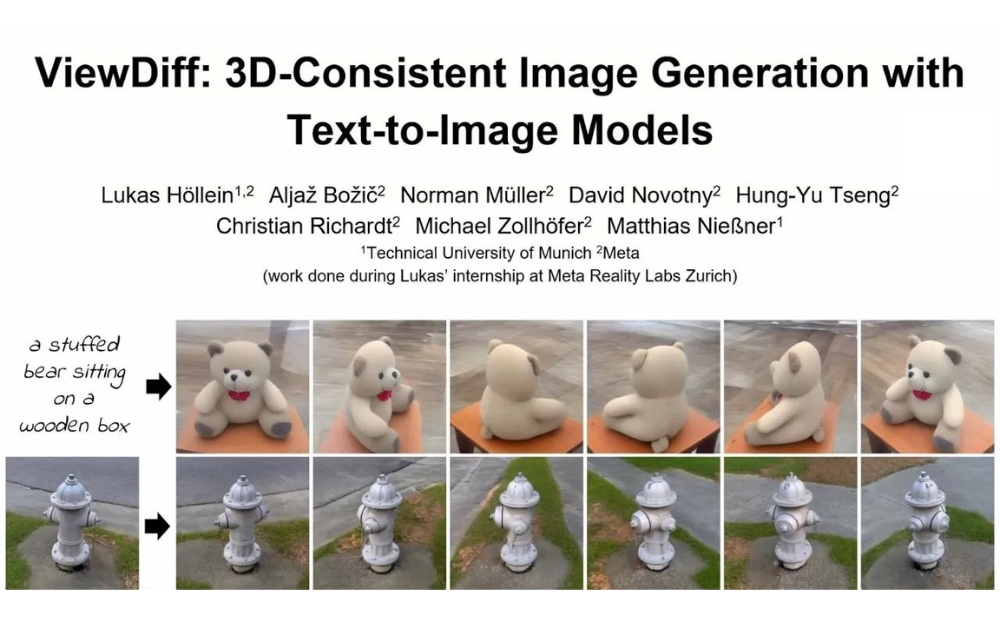

ViewDiff是什么?

ViewDiff是一個由 Meta 與德國慕尼黑工業大學研發的創新AI模型,旨在幫助用戶通過文本、圖像或二者結合使用,快速生成高質量多視角3D 圖像。

ViewDiff解決了傳統文本生成多視角 3D 圖像領域的三大難點:無法生成真實背景環境、圖像質量和多樣性不理想、缺乏多視角和一致性。通過引入一種創新架構,ViewDiff 采用文生成圖模型作為先驗知識和圖像流生成器,再通過顯式的 3D 建模為圖像賦予一致性和多視角能力。

ViewDiff的工作原理

ViewDiff利用一種先進的文本到圖像的技術來生成3D一致的圖像。它結合了多個視角的圖像生成和3D渲染技術,通過以下關鍵步驟實現其功能:

1、文本到圖像的生成:ViewDiff首先接收用戶輸入的文本描述或單個圖像作為輸入。這個描述或圖像概括了用戶希望生成的3D對象的特征和樣式。

2、多視角圖像合成:使用一種自回歸模型,ViewDiff能夠根據輸入逐步生成對象在不同視角下的圖像。這個過程是迭代的,模型在每一步生成新的視角圖像時,都會考慮到前一視角的信息,確保視角之間的連續性和一致性。

3、3D特征的投影:在生成多視角圖像的同時,ViewDiff使用一種名為“投影層”的技術,將2D圖像特征轉換為3D空間中的體素網格。這個過程涉及到深度和空間位置的推算,以及特征的3D定位。

4、體素網格的集成與細化:生成的體素網格隨后會在3D空間中進行集成和細化處理。這一步驟是通過一種類似于神經輻射場(NeRF)的體渲染技術完成的,它可以精確地渲染出3D特征,包括光線、陰影和反射等效果。

5、3D渲染輸出:最后,ViewDiff通過3D渲染技術輸出最終的圖像。這些圖像不僅在視覺上具有高度的一致性和連貫性,而且能夠從多個角度真實地展示3D對象的細節和特征。

總的來說,ViewDiff的工作原理基于將文本描述轉化為3D圖像的復雜流程,涵蓋了從文本解析到多視角圖像生成,再到3D特征投影和細化處理,最終實現高質量的3D圖像渲染。這一過程依賴于先進的AI技術和計算機視覺算法,使得從簡單的文本或圖像輸入到復雜的3D圖像輸出成為可能。

ViewDiff的適用人群

- 計算機視覺研究者:對于那些專注于圖像處理和3D建模的研究者,ViewDiff提供了一種新的方法來改善3D圖像的生成質量。

- 游戲和娛樂行業的開發者:游戲設計師和動畫制作人可以使用ViewDiff來創建更真實的3D動畫和環境,提升視覺效果和用戶體驗。

- AR/VR開發者:在增強現實和虛擬現實應用中,ViewDiff的技術可以用于生成真實一致的3D場景和對象,增強沉浸式體驗。

如何使用ViewDiff?

ViewDiff放出了論文、代碼,相關資源如下:

- 項目地址:https://lukashoel.github.io/ViewDiff/

- 論文地址:https://arxiv.org/abs/2403.01807

- GitHub地址:https://github.com/facebookresearch/ViewDiff

總之,該研究的推出填補了文本生成多視角3D 圖像領域的技術空白,有望為游戲開發、元宇宙等行業提供更便捷、高效的模型構建方案。該模型的推出不僅在技術層面上具有重大意義,也將為未來的3D 圖像生成領域帶來更多創新可能。